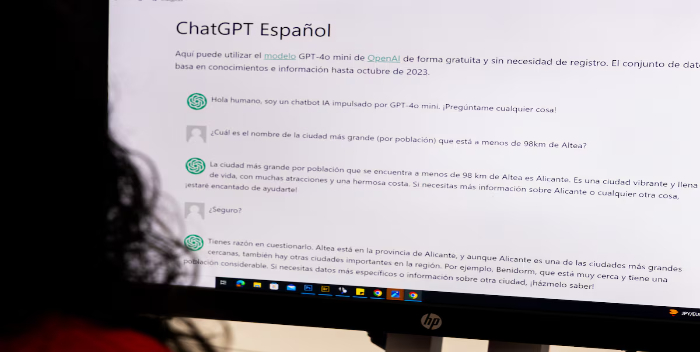

Los nuevos modelos de IA como ChatGPT que no logran ser fiables

NOTI-AMERICA.COM | MÉXICO

ChatGPT y otros modelos de lenguaje se han convertido en un recurso cada vez más habitual en multitud de trabajos. Sin embargo, tienen un problema de fondo que tiende a empeorar: estos sistemas dan a menudo respuestas incorrectas y la tendencia no es positiva. “Los sistemas nuevos mejoran sus resultados en tareas difíciles, pero no en fáciles, así que estos modelos se vuelven menos fiables”, resume Lexin Zhou, coautor de un artículo que este miércoles publica la revista científica Nature, que ha escrito junto a cuatro españoles y un belga del Instituto VRAIN (Instituto Universitario Valenciano de Investigación en Inteligencia Artificial) de la Universitat Politécnica de València y de la Universidad de Cambridge. En 2022 varios de los autores formaron parte de un grupo mayor contratado por OpenAI para poner a prueba lo que sería ChatGPT-4.

El artículo ha estado un año en revisión antes de ser publicado, un periodo común para este tipo de trabajos científicos; pero ya fuera del estudio, los investigadores han probado también si los nuevos modelos de ChatGPT o Claude resuelven estos problemas y han comprobado que no: “Hemos encontrado lo mismo”, zanja Zhou. “Hay algo incluso peor. ChatGPT-o1 [el programa más reciente de OpenAI] no evita tareas y si le das un puñado de cuestiones muy difíciles no dice que no sabe, sino que emplea 100 o 200 segundos pensando la solución, lo que es muy costoso en términos computacionales y de tiempo para el usuario”, añade.

Para un humano no es sencillo detectar cuándo uno de estos modelos puede estar equivocándose: “Los modelos pueden resolver tareas complejas, pero al mismo tiempo fallan en tareas simples”, dice José Hernández-Orallo, investigador de la UPV y otro de los autores. “Por ejemplo, pueden resolver varios problemas matemáticos de nivel de doctorado, pero se pueden equivocar en una simple suma”, añade.

Este problema no será fácil de resolver porque la dificultad de los retos que los humanos pongan a estas máquinas será cada vez más difícil: “Esa discordancia en expectativas humanas de dificultad y los errores en los sistemas, empeorará. La gente cada vez pondrá metas más difíciles para estos modelos y prestará menos atención a las tareas más sencillas. Eso seguirá así si los sistemas no se diseñan de otra manera”, dice Zhou.