Un estudio reciente de Media Matters —organización sin ánimo de lucro de tendencia izquierdista— ha descubierto que el algoritmo de TikTok detecta que, si un usuario interactúa únicamente con contenidos y creadores transfóbicos, el algoritmo de la aplicación de redes sociales empezará a poblar gradualmente su página “Para ti” con vídeos de supremacía blanca, antisemitas y de extrema derecha, así como con llamamientos a la violencia.

Lanzada en 2016 por la startup tecnológica china ByteDance, TikTok experimentó un aumento de usuarios a lo largo de la pandemia del COVID-19 y adquirió mil millones de usuarios en todo el mundo en cinco años, muchos de los cuales son adolescentes y adultos jóvenes.

En 2020, la aplicación clasificó a más de un tercio de sus usuarios diarios de 14 años o menos, informó The New York Times. Un antiguo empleado de TikTok señaló que los vídeos y las cuentas hechas por niños que parecían más jóvenes que el requisito de edad mínima de la app, 13 años, podían permanecer en línea durante semanas, lo que plantea dudas sobre las medidas adoptadas por la plataforma para proteger a sus usuarios de la desinformación, el discurso de odio e incluso el contenido violento, esto de acuerdo con Bussines Insider.

El algoritmo de TikTok ¿promueve la radicalización y el odio?

El algoritmo de TikTok

En el experimento, los investigadores de Media Matters crearon una cuenta ficticia, interactuaron con contenido antitrans y luego evaluaron los primeros 400 vídeos introducidos en la cuenta que el algoritmo de TikTok arrojó.

Algunos de los vídeos se eliminaron antes de poder analizarlos, mientras que otros eran anuncios patrocinados no relacionados con el estudio. De los 360 vídeos restantes, los investigadores descubrieron que:

- 103 contenían narrativas antitrans y/o homófobas.

- 42 eran misóginos.

- 29 contenían relatos racistas o mensajes de supremacía blanca.

- 14 apoyaban la violencia.

Aunque casi 400 puede parecer un gran número de vídeos, si un usuario ve los vídeos durante una media de 20 segundos cada uno, podría consumir 400 vídeos en poco más de dos horas.

Un usuario podría descargar la aplicación durante el desayuno y recibir contenidos abiertamente supremacistas y neonazis antes del almuerzo.

Estudio.

El movimiento de extrema derecha ha abrazado históricamente la retórica antitrans, y los reclutadores de la derecha saben que las “ideas más suaves”, como la transfobia, pueden utilizarse para introducir a los recién llegados a creencias más extremas, comentó a Insider Melody Devries, candidata al doctorado de la Universidad Ryerson que estudia el reclutamiento y la movilización de la extrema derecha.

Consecuencias imprevistas de la era digital

Antes del auge de las redes sociales, las personas formaban sus creencias principalmente a través de las redes de relaciones del mundo real con sus padres, familiares y amigos.

Sin embargo, las plataformas de los medios sociales permitieron a los individuos ampliar estas redes sociales mediante la creación de comunidades en entornos online y otros factores como el algoritmo de TikTok.

La rápida expansión y evolución de los espacios digitales ha trasladado los contenidos e ideologías extremistas de los rincones de Internet a plataformas frecuentadas por miles de millones de usuarios.

Ahora, Facebook, Instagram, Twitter, todas nuestras plataformas de comunicación que consideramos más fáciles de usar pueden ser el punto de partida de la radicalización. Y luego una persona puede pasar a aplicaciones más estratificadas que son más difíciles de penetrar.

Thomas Holt, profesor y director de la escuela de justicia penal de la Universidad Estatal de Michigan.

El algoritmo de TikTok ¿promueve la radicalización y el odio?

Según el Consorcio Nacional para el Estudio del Terrorismo y las Respuestas al Terrorismo (NCSTRT), el papel de las redes sociales en el extremismo ha aumentado drásticamente en los últimos años.

En 2012, solo el 48% de los extremistas incluidos en los Perfiles de Radicalización Individual en Estados Unidos (PIRUS) —un conjunto de datos del NCSTRT— dijeron que los medios sociales desempeñaron un papel en su radicalización. En 2016, el 86,75% de los extremistas incluidos en PIRUS utilizaron las redes sociales en su proceso de radicalización, según un informe de investigación del NCSTRT.

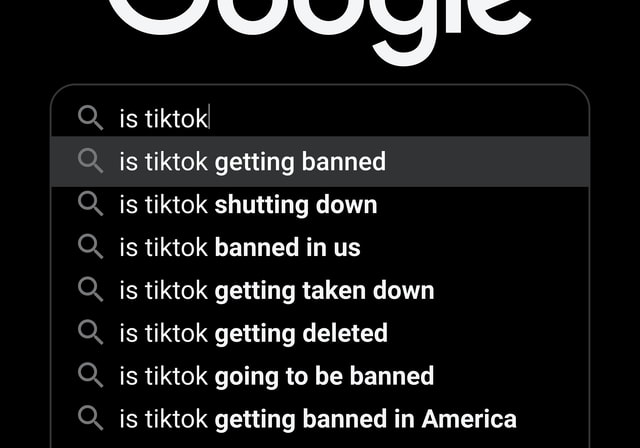

Holt mencionó Facebook, Instagram y Twitter, todas ellas con una década o más de antigüedad. Pero en los últimos cinco años, TikTok se ha convertido en una de las plataformas de medios sociales de más rápido crecimiento de todos los tiempos, conocida por su potente algoritmo que sirve videos muy adaptados.

Cuenta con más de 100 millones de usuarios diarios en EE.UU., según la CNBC, y recientemente se ha convertido en el centro de un mayor escrutinio en torno a su algoritmo, que según los creadores negros y LGBTQ+ censura sus voces y perpetúa el acoso selectivo.

Cómo las grandes empresas tecnológicas racionalizaron la autorradicalización

Dado que los modelos de beneficios de las redes sociales dependen en gran medida de la participación de los usuarios, la mayoría de las empresas optan por tomar el proverbial “camino del medio” a la hora de moderar los contenidos para evitar acusaciones de censura por parte de ambos lados del espectro político y, en última instancia, perjudicar sus resultados, según Devries.

El hecho de que esas plataformas estén totalmente de acuerdo con eso, es porque ese es su motivo de lucro y su diseño, creo que es un problema y obviamente contribuye a cómo se transforma la comunicación de la derecha.

Melody Devries, candidata al doctorado de la Universidad Ryerson

El sonido, que se ha utilizado en más de 1.200 vídeos, se ha hecho popular en el TikTok de derechas.

En los vídeos que hemos revisado, a menudo se combina con montajes de capturas de pantalla de personas LGBTQ+ que transmiten en directo en TikTok.

Estos vídeos no solo utilizan un audio que rinde homenaje a un terrorista, sino que también promueven el acoso a los usuarios LGBTQ+ de TikTok.

Investigadores de Media Matters.

El algoritmo de TikTok ¿promueve la radicalización y el odio?

Aunque el sonido “Teddy” puede no violar explícitamente las directrices de la plataforma, los vídeos que lo utilizan comunican con frecuencia mensajes odiosos, peligrosos e incluso violentos si se tiene en cuenta el contenido completo, incluidos otros componentes como los visuales y el texto.

Internet se ha convertido en un recurso fundamental para los grupos extremistas, y las lagunas en las directrices de la comunidad les permiten promover sus ideologías a un público más amplio de forma sutil y convincente, según la investigación de Holt en Deviant Behavior.

“Independientemente de que los espectadores lo crean inicialmente o no, con el tiempo, estas interacciones con ese contenido van desgastando poco a poco su sistema de creencias ideológicas y construyen uno nuevo basado en las ideas presentadas en este contenido”, dijo Devries.

Detener las interacciones en línea con contenidos extremistas

Las repercusiones de la desinformación y la radicalización propagadas por las redes sociales se han sentido en todo el mundo durante años.

“No se trata sólo de Estados Unidos. Todos los países se ven afectados de alguna manera por el uso y el mal uso de las plataformas de los medios sociales para la desinformación, la desinformación o la radicalización. Hay una necesidad inherente de una mejor regulación, una mejor gestión de las plataformas y, en la medida en que pueda proporcionarse, transparencia en torno a la denuncia y la eliminación”, declaró Holt a Insider.

Sin embargo, añadió Devries, no se trata de presentar hechos contrarios, sino que hay que poner fin a las propias interacciones. En su análisis etnográfico de los espacios de extrema derecha en Facebook, Devries ha visto que la plataforma añade infografías que advierten de que una publicación contiene información errónea en un intento de moderar el contenido, un enfoque que considera contraintuitivo.

La gente no solo interactúa con el contenido falso en sí, sino con el hecho de que Facebook ha intentado censurarlo. Así que la propia infografía se convierte en otra pieza de contenido con la que pueden interactuar y atraer a su ideología.

Investigadores de Media Matters.

Cuando se le pidió un comentario, un portavoz de Facebook sostuvo que la empresa trata de dar al máximo número de personas una experiencia positiva en Facebook y toma medidas para mantener a la gente segura, incluyendo la asignación de 5.000 millones de dólares durante el próximo año fiscal para la seguridad.

Cuando una investigación del Wall Street Journal sacó a la luz cómo Facebook hizo proliferar los daños en el mundo real al no moderar la incitación al odio y la desinformación, la empresa reconoció en un blog de septiembre de 2021 que “no abordó los retos de seguridad y protección con suficiente antelación en el proceso de desarrollo del producto”.

En lugar de buscar soluciones reactivas como la moderación de contenidos a través de el algoritmo de TikTok, Holt propone que las empresas de medios sociales mitiguen el extremismo en línea en sus plataformas mediante la aplicación de soluciones como las utilizadas para eliminar el contenido de explotación sexual infantil.

Herramientas como PhotoDNA de Microsoft se utilizan para detener la recirculación en línea de contenidos de explotación sexual infantil mediante la creación de un “hash”, que funciona como una especie de huella digital que puede compararse con una base de datos de imágenes ilegales compilada por organizaciones y empresas de vigilancia, según Microsoft.

El algoritmo de TikTok ¿promueve la radicalización y el odio?

Si este tipo de tecnología se superpusiera a las redes sociales, Holt dijo que podría automatizarse para retirar contenidos asociados al extremismo o a ideologías violentas.

Sin embargo, esta solución depende de que las plataformas de medios sociales realicen cambios internos como el caso de el algoritmo de TikTok. Mientras tanto, Holt aboga por una mejor educación del público sobre estas plataformas y cómo utilizarlas de forma responsable.

Fuente: EXPOK